AMD wypuszcza akcelerator MI300X, konkurujący z NVIDIA H100

Podczas wydarzenia Advancing AI firma AMD zaprezentowała akceleratory Instinct MI300X, oferujące wiodącą w branży przepustowość generatywnej sztucznej inteligencji, a także jednostkę przyspieszonego przetwarzania (APU) Instinct MI300A w połączeniu z najnowszą architekturą AMD CDNA 3 i procesorami Zen 4 – wszystkie przeznaczone dla HPC i obciążenia AI.

Klienci, w tym Microsoft, ogłosili już, że wykorzystają portfolio akceleratorów AMD Instinct w niedawno wydanej serii maszyn wirtualnych Azure ND MI300x v5, która jest specjalnie zoptymalizowana pod kątem obciążeń IA. Meta dodaje także akceleratory MI300X do swoich centrów danych.

OpenAI dodaje także obsługę akceleratorów AMD Instinct do Triton 3.0, zapewniając obsługę akceleratorów AMD, co umożliwi programistom testowanie ich modeli.

Ponadto, Infrastruktura chmurowa Oracle (OCI) planuje dodać instancje bare metal oparte na MI300X do swoich wysokowydajnych, akcelerowanych systemów obliczeniowych. Będzie to obsługiwać Supercluster OCI z ultraszybką siecią RDMA.

Ponadto firma Dell zaprezentowała podczas wydarzenia swój serwer Dell PowerEdge XE9680, który jest wyposażony w osiem akceleratorów AMD z serii Instinct MI300 oraz platformy AI oparte na AMD ROCm.

Czytać: AMD Eyes wielkie zwycięstwa dzięki MI300X do obciążeń AI

Nie tylko Dell, HPE i Lenovo również korzystają z ekosystemu AMD Instinct. HPE ogłosiło Cray Supercomputing EX255a, swój pierwszy akcelerator superkomputerowy napędzany jednostkami APU Instinct MI300A. Będą one dostępne na początku 2024 roku.

Lenovo ogłosiło wsparcie projektowe dla akceleratorów serii MI300, których dostępność planowana jest na pierwszą połowę 2024 roku. Supermicro ogłosiło także wprowadzenie na rynek generacji akcelerowanych serwerów H13, które będą zasilane procesorami AMD EPYC 4. generacji i akceleratorami MI300.

„Akceleratory AMD Instinct serii MI300 zostały zaprojektowane z wykorzystaniem naszych najbardziej zaawansowanych technologii, zapewniając wiodącą wydajność. Akceleratory te będą wykorzystywane we wdrożeniach chmurowych i korporacyjnych na dużą skalę” – powiedział Victor Peng, prezes AMD. „Wykorzystując nasz wiodący sprzęt, oprogramowanie i podejście do otwartego ekosystemu, dostawcy usług w chmurze, producenci OEM i ODM wprowadzają na rynek technologie, które umożliwiają przedsiębiorstwom przyjmowanie i wdrażanie rozwiązań opartych na sztucznej inteligencji”.

Gigabytes, Inventec, QCT, Ingensys i Wistron również ogłosiły swoje plany zaoferowania rozwiązań opartych na nowych akceleratorach AI.

Inni wyspecjalizowani dostawcy rozwiązań chmurowych, w tym Aligned, Arkon Energy, Cirrascale, Crusoe, Denver Dataworks i Tensorwaves, zamierzają włączyć i rozszerzyć dostęp do procesorów graficznych MI300X dla programistów i start-upów zajmujących się sztuczną inteligencją.

Ponadto El Capitan, superkomputer eksaskalowy w Lawrence Livermore National Laboratory, również gości niezapowiedzianą liczbę MI300, opierając się na szumie wokół tej premiery. Oczekuje się, że po pełnym wdrożeniu zapewni dwa eksaflopy wydajności o podwójnej precyzji.

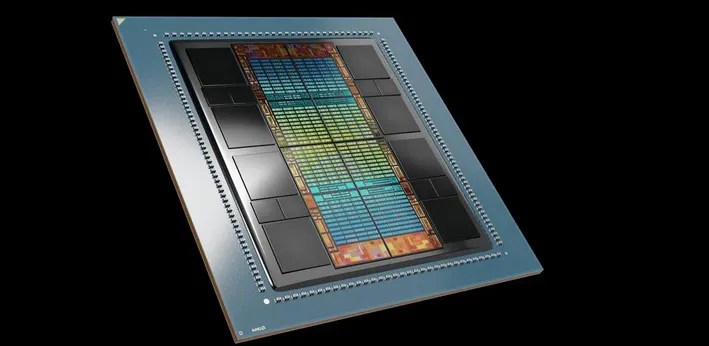

Dane techniczne MI300X

Akceleratory AMD Instinct MI300X wykorzystują nową architekturę AMD CDNA 3. W porównaniu do akceleratorów AMD Instinct M1250X poprzedniej generacji, MI300X ma prawie 40% więcej jednostek obliczeniowych, 1,5 razy większą pojemność pamięci i 1,7 razy większą teoretyczną przepustowość pamięci. Dodatkowo MI300X obsługuje nowe formaty matematyczne, takie jak FP8, zaprojektowane specjalnie dla obciążeń AI i HPC.

Akceleratory oferują szerokie możliwości pamięci i obliczeń. Wyposażone w pamięć HBM3 o szczytowej przepustowości 5,3 TB/s i najlepszej w swojej klasie przepustowości 192 GB, akceleratory te zaspokajają wymagający charakter obciążeń AI.

Platforma AMD Instinct, zbudowana w oparciu o standardową w branży konstrukcję OCP, zawiera osiem akceleratorów MI300X, zapewniających łącznie 1,5 TB pojemności pamięci HBM3. Platforma ta umożliwia partnerom OEM bezproblemową integrację akceleratorów M1300X z istniejącą ofertą AI.

W porównaniu do NVIDIA H100 HGX, platforma AMD Instinct zapewnia nawet 1,6-krotny wzrost wydajności. Jest to szczególnie zauważalne podczas uruchamiania wnioskowania na LLM, takich jak BLOOM 176B4 i Llama2, z pojedynczym akceleratorem M1300X.

Dane techniczne MI300A

AMD Instinct MI300A to jednostka przyspieszonego przetwarzania (APU) zaprojektowana specjalnie do zastosowań w centrach danych, co stanowi znaczący postęp jako pierwszy na świecie APU dostosowany do obciążeń HPC i AI.

U podstaw MI300A znajdują się wysokowydajne rdzenie GPU AMD CDNA 3 w połączeniu z najnowszymi rdzeniami procesorów AMD „Zen 4” x86, tworząc potężną synergię w zadaniach obliczeniowych. Dzięki 128 GB pamięci HBM3 nowej generacji, MI300A może poszczycić się imponującymi możliwościami, zapewniając niezwykłą ~1,9-krotną poprawę wydajności na wat w przypadku obciążeń HPC i AI w porównaniu do swojego poprzednika.

Nacisk na efektywność energetyczną jest sprawą najwyższej wagi, szczególnie biorąc pod uwagę wymagania związane z obciążeniami HPC i AI, które z natury wymagają dużej ilości danych i obliczeń. Integrując rdzenie procesora i karty graficznej w jednym APU, MI300A osiąga 30-krotną poprawę efektywności energetycznej w porównaniu z FP32, odpowiadając na krytyczną potrzebę optymalizacji zasilania.