Brytyjska agencja udostępnia narzędzia do testowania bezpieczeństwa modeli AI

Brytyjski Instytut Bezpieczeństwa, niedawno utworzony brytyjski organ ds. bezpieczeństwa sztucznej inteligencji, udostępnił zestaw narzędzi zaprojektowany w celu „wzmocnienia bezpieczeństwa sztucznej inteligencji” poprzez ułatwienie przemysłowi, organizacjom badawczym i środowisku akademickim opracowywania ocen sztucznej inteligencji.

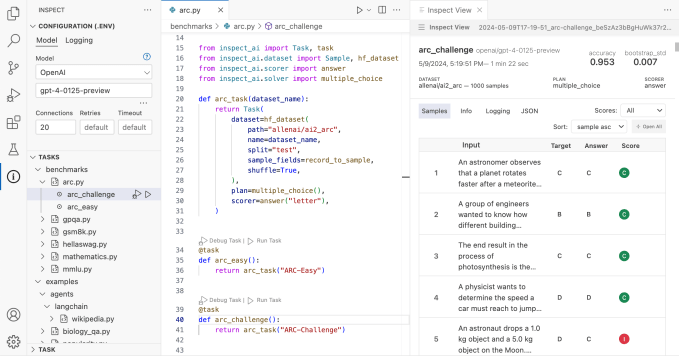

Zestaw narzędzi o nazwie Inspect – dostępny na licencji open source, w szczególności licencji MIT – ma na celu ocenę niektórych możliwości modeli sztucznej inteligencji, w tym podstawowej wiedzy modeli i zdolności do rozumowania, a także wygenerowanie wyniku na podstawie wyników.

W piątkowym komunikacie prasowym ogłaszającym tę wiadomość Instytut Bezpieczeństwa stwierdził, że Inspect to „pierwszy przypadek udostępnienia do szerszego użytku platformy do testowania bezpieczeństwa sztucznej inteligencji, na której czele stoi organ wspierany przez państwo”.

„Udana współpraca w zakresie testowania bezpieczeństwa sztucznej inteligencji oznacza wspólne, przystępne podejście do ocen i mamy nadzieję, że Inspect może stać się elementem składowym” – powiedział w oświadczeniu przewodniczący Safety Institute Ian Hogarth. „Mamy nadzieję, że globalna społeczność AI będzie korzystać z Inspect nie tylko do przeprowadzania własnych testów bezpieczeństwa modeli, ale także do pomocy w adaptacji i rozwijaniu platformy open source, abyśmy mogli tworzyć wysokiej jakości oceny we wszystkich obszarach”.

Jak pisaliśmy wcześniej, testy porównawcze sztucznej inteligencji są trudne — między innymi dlatego, że najbardziej wyrafinowane obecnie modele sztucznej inteligencji to czarne skrzynki, których infrastruktura, dane szkoleniowe i inne kluczowe szczegóły są trzymane w tajemnicy przez tworzące je firmy. Jak zatem Inspect radzi sobie z tym wyzwaniem? Głównie poprzez możliwość rozszerzenia i rozszerzenia na nowe techniki testowania.

Inspect składa się z trzech podstawowych komponentów: zbiorów danych, solwerów i scoringerów. Zestawy danych dostarczają próbek do testów ewaluacyjnych. Solvery wykonują pracę polegającą na przeprowadzaniu testów. Osoby oceniające oceniają pracę osób rozwiązujących i sumują wyniki z testów w postaci wskaźników.

Wbudowane komponenty Inspect można rozszerzyć za pomocą pakietów innych firm napisanych w języku Python.

W poście na portalu X Deborah Raj, badaczka w Mozilli i znana etyka AI, nazwała Inspect „świadectwem siły inwestycji publicznych w narzędzia open source zwiększające odpowiedzialność za sztuczną inteligencję”.

Clément Delangue, dyrektor generalny startupu Hugging Face zajmującego się sztuczną inteligencją, podsunął pomysł zintegrowania Inspect z biblioteką modeli Hugging Face lub stworzenia publicznej tablicy wyników zawierającej wyniki ocen zestawu narzędzi.

Publikacja Inspect następuje po tym, jak agencja rządowa stanu — Narodowy Instytut Standardów i Technologii (NIST) — uruchomiła NIST GenAI, program oceniający różne technologie generatywnej sztucznej inteligencji, w tym sztuczną inteligencję generującą tekst i obrazy. NIST GenAI planuje udostępnić testy porównawcze, pomóc w tworzeniu systemów wykrywania autentyczności treści i zachęcać do rozwoju oprogramowania do wykrywania fałszywych lub wprowadzających w błąd informacji generowanych przez sztuczną inteligencję.

W kwietniu Stany Zjednoczone i Wielka Brytania ogłosiły partnerstwo w celu wspólnego opracowywania zaawansowanych testów modeli sztucznej inteligencji, w następstwie zobowiązań ogłoszonych podczas brytyjskiego szczytu dotyczącego bezpieczeństwa sztucznej inteligencji w Bletchley Park w listopadzie ubiegłego roku. W ramach współpracy Stany Zjednoczone zamierzają uruchomić własny instytut bezpieczeństwa sztucznej inteligencji, którego głównym zadaniem będzie ocena zagrożeń związanych ze sztuczną inteligencją i sztuczną inteligencją generatywną.