Gemini, agenci AI i nowy Asystent Google w Pixelu 4

Ostatnio coraz częściej mówi się o agentach AI, którzy przyjmują polecenia i fizycznie wykonują zadania, łącznie z niezbędnymi dotknięciami i przesunięciami na Twoim telefonie. Ta rozmowa o budowaniu agenta AI bardzo przypomina mi „nowego Asystenta Google”, który został ogłoszony wraz z Pixelem 4 w 2019 roku.

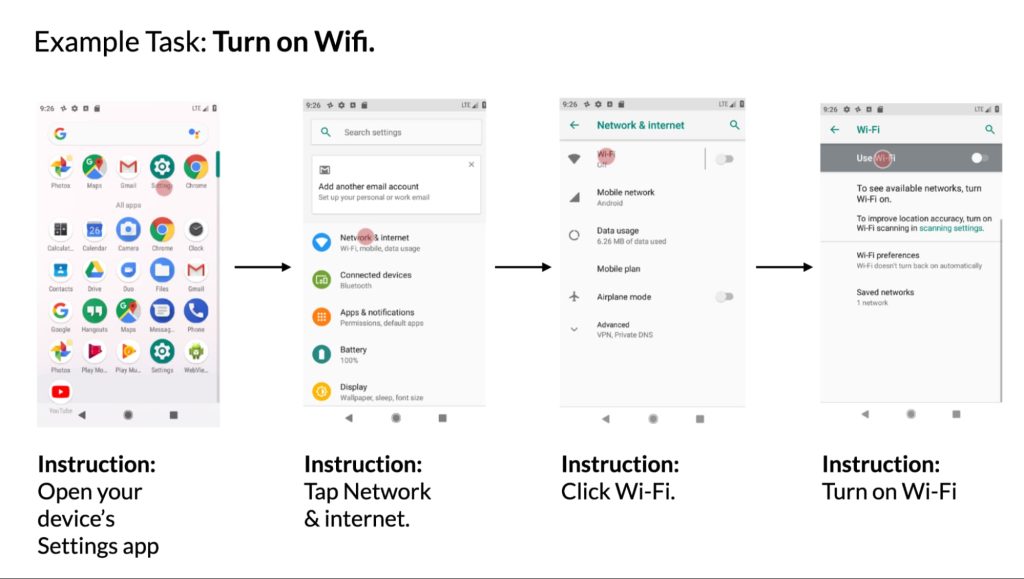

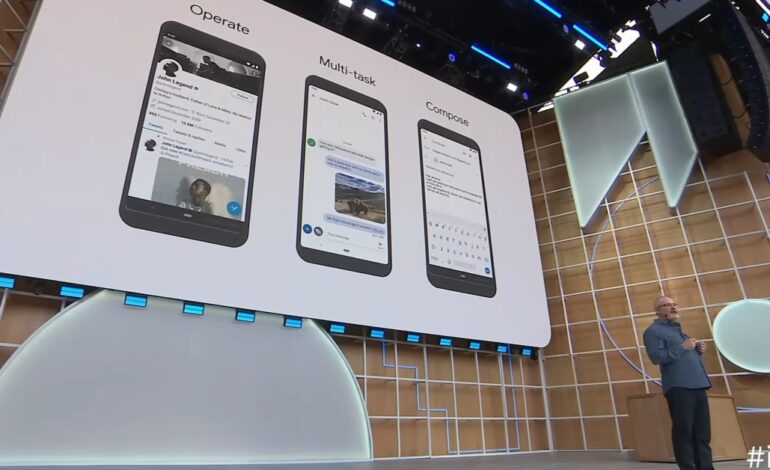

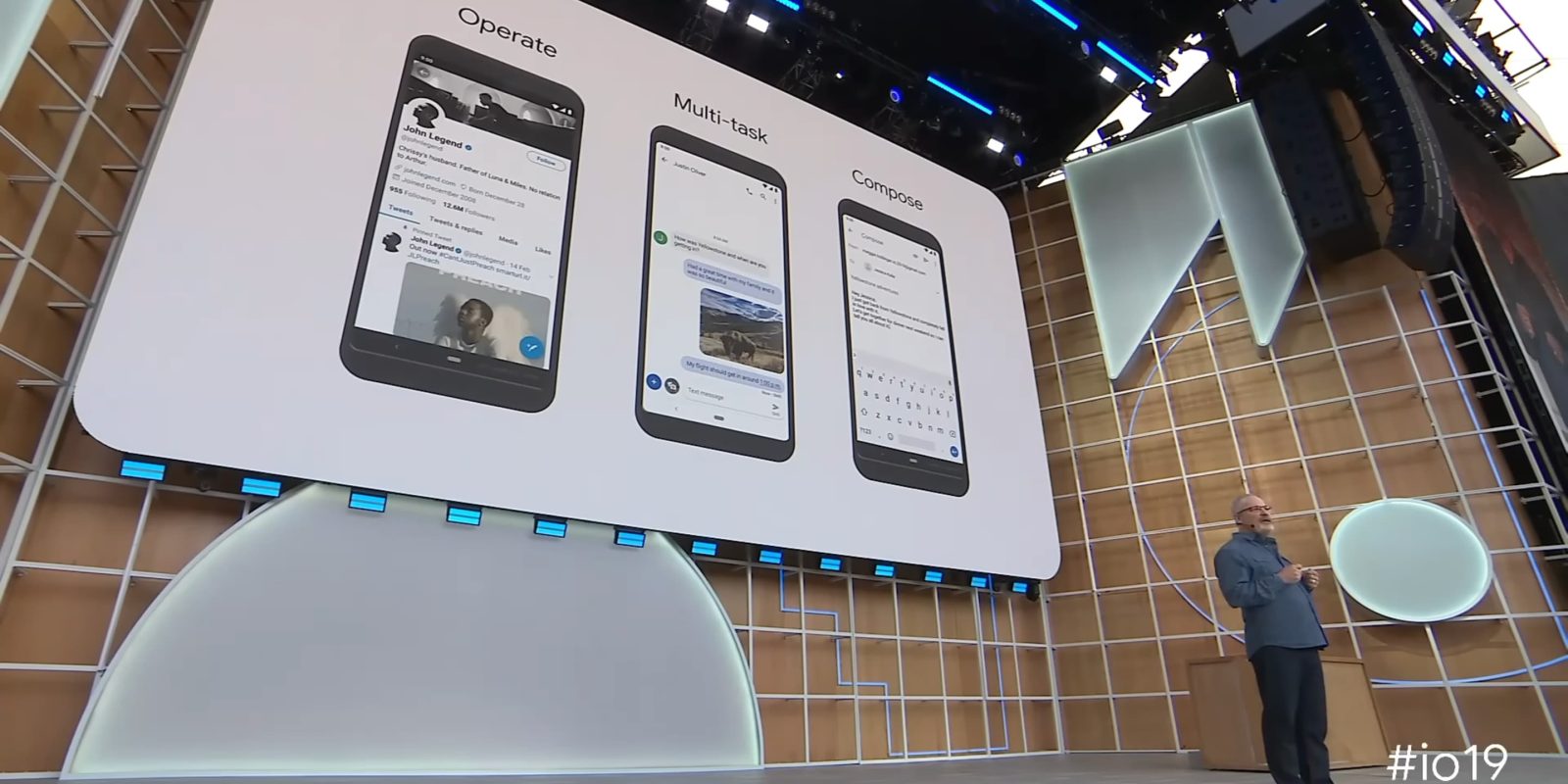

Na targach I/O 2019 Google po raz pierwszy zaprezentował Asystenta nowej generacji. Założenie było takie, że przetwarzanie głosu na urządzeniu sprawi, że „stukanie w celu obsługi telefonu będzie wydawać się prawie powolne”.

Google zademonstrował proste polecenia, które obejmują otwieranie aplikacji i kontrolowanie ich, podczas gdy bardziej złożony pomysł dotyczył tego, „w jaki sposób Asystent połączony z urządzeniem może koordynować zadania między aplikacjami”. Przykładem było otrzymanie przychodzącej wiadomości tekstowej, udzielenie odpowiedzi głosowej, a następnie pomysł wyszukania i wysłania dołączonego zdjęcia. Możliwość „Operacji” i „Wielozadaniowości” została uzupełniona funkcją „Tworzenia” w języku naturalnym w Gmailu.

Ten Asystent nowej generacji umożliwi Ci natychmiastową obsługę telefonu za pomocą głosu, wykonywanie wielu zadań jednocześnie w aplikacjach i wykonywanie złożonych czynności, a wszystko to przy niemal zerowym opóźnieniu.

Nowy Asystent pojawił się na Pixelu 4 jeszcze w tym samym roku i był dostępny na wszystkich kolejnych urządzeniach Google.

- „Zrobić selfie.” Następnie powiedz „Udostępnij to Ryanowi”.

- W wątku na czacie powiedz „Odpowiedz, już idę”.

- „Wyszukaj zajęcia jogi w YouTube”. Następnie powiedz „Udostępnij to mamie”.

- „Pokazuj mi e-maile od Michelle w Gmailu”.

- Po otwarciu aplikacji Zdjęcia Google powiedz „Pokaż mi zdjęcia Nowego Jorku”. Następnie powiedz „Te w Central Parku”.

- Po otwarciu witryny z przepisami w przeglądarce Chrome powiedz „Wyszukaj ciasteczka czekoladowe z orzechami”.

- Po otwarciu aplikacji turystycznej powiedz „Hotele w Paryżu”.

Jest to podstawowa idea agentów AI. W zeszłym miesiącu podczas rozmowy telefonicznej dotyczącej zarobków w Alphabet Sundar Pichai został zapytany o wpływ generatywnej sztucznej inteligencji na Asystenta. Powiedział, że pozwoli to Asystentowi Google „działać z czasem bardziej jak agent” i „wykraczać poza odpowiedzi i podążać za użytkownikami”.

Według Informacja w tym tygodniu OpenAI pracuje nad takim agentem ChatGPT:

„Według osoby mającej wiedzę na temat tego rodzaju żądań agent będzie wykonywał kliknięcia, ruchy kursora, wpisywanie tekstu i inne czynności podejmowane przez ludzi podczas pracy z różnymi aplikacjami”.

Następnie jest Rabbit ze swoim dużym modelem działania (LAM) przeszkolonym do interakcji z istniejącymi interfejsami mobilnymi i stacjonarnymi w celu wykonania ustalonego zadania.

Wersja Asystenta Google w 2019 r. wydawała się bardzo wstępnie zaprogramowana i wymagała od użytkowników trzymania się określonego sformułowania, a nie pozwalania ludziom mówić naturalnie, a następnie automatycznie rozpoznawać akcję. Google stwierdził wówczas, że Asystent „działa bezproblemowo z wieloma aplikacjami” i że „z biegiem czasu będzie w dalszym ciągu ulepszać integrację aplikacji”. Według naszej wiedzy tak się nigdy nie stało, a niektóre funkcje zaprezentowane przez Google przestały działać po zmianie aplikacji. Prawdziwy agent byłby w stanie się dostosować, zamiast polegać na ustalonych warunkach.

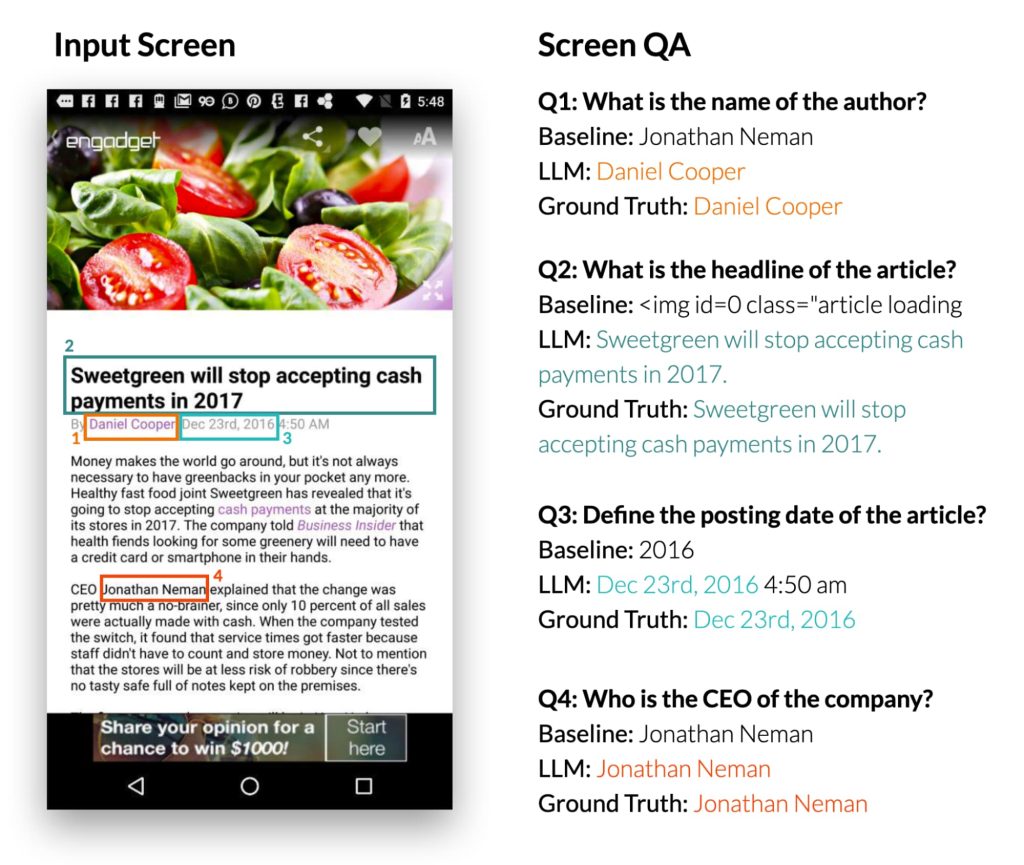

Łatwo zobaczyć, jak menedżerowie LLM mogliby ulepszyć tę kwestię, gdyż w zeszłym roku zespół badawczy Google pochwalił się pracą nad „Umożliwieniem interakcji konwersacyjnej za pomocą mobilnego interfejsu użytkownika przy użyciu modeli wielkojęzycznych”.

Badania Google wykazały, że ich podejście pozwala „szybko zrozumieć cel mobilnego interfejsu użytkownika”:

Co ciekawe, zaobserwowaliśmy, że osoby z wykształceniem wyższym wykorzystują swoją wcześniejszą wiedzę do wywnioskowania informacji, które nie są prezentowane w interfejsie użytkownika podczas tworzenia podsumowań. W poniższym przykładzie LLM wywnioskował, że stacje metra należą do systemu London Tube, podczas gdy wejściowy interfejs użytkownika nie zawiera tej informacji.

Potrafi także odpowiadać na pytania dotyczące treści, które pojawiły się w interfejsie użytkownika, a także kontrolować je po otrzymaniu instrukcji w języku naturalnym.

Agent Gemini AI dla Twojego urządzenia z Androidem byłby naturalną ewolucją pierwszej próby Google, która nigdy tak naprawdę nie przyjęła się jako wszechstronny Asystent zapewniający nowy sposób korzystania z telefonu. Jednak funkcje takie jak transkrypcja odpowiedzi na wiadomość, a następnie możliwość powiedzenia „wyślij” na żywo podczas pisania głosowego Asystenta Gboard.

Wygląda na to, że poprzednie wysiłki wynikały z tego, że Google za wcześnie wpadło na pomysł i nie posiadało wymaganej technologii. Skoro już to osiągnęliśmy, Google mądrze byłoby nadać tym wysiłkom priorytet, tak aby mogła zacząć przewodzić na boisku, zamiast go doganiać.

FTC: Korzystamy z automatycznych linków partnerskich generujących dochód. Więcej.