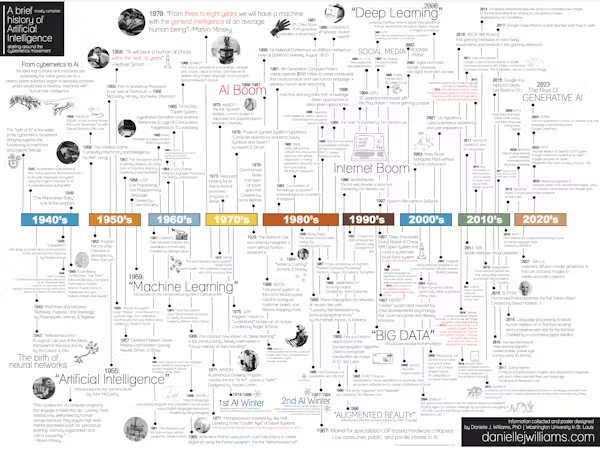

Kalendarium sztucznej inteligencji (AI) od lat czterdziestych XX wieku do chwili obecnej

Komputer wielkości pokoju, wyposażony w nowy typ obwodów, Perceptron, został przedstawiony światu w 1958 roku w krótkim artykule prasowym głęboko zakopanym w „The New York Times”. W artykule przytoczono wypowiedź Marynarki Wojennej Stanów Zjednoczonych, która stwierdziła, że Perceptron doprowadzi do powstania maszyn, które „będą mogły chodzić, mówić, widzieć, pisać, reprodukować się i mieć świadomość swojego istnienia”.

Ponad sześćdziesiąt lat później podobne twierdzenia pojawiają się na temat współczesnej sztucznej inteligencji. Co zatem zmieniło się przez te lata? W pewnym sensie niewiele.

Od samego początku dziedzina sztucznej inteligencji przeżywa okres wzlotów i upadków. Teraz, gdy dziedzina ta przeżywa kolejny rozkwit, wydaje się, że wielu zwolenników tej technologii zapomniało o niepowodzeniach z przeszłości i ich przyczynach. Choć optymizm napędza postęp, warto zwrócić uwagę na historię.

Perceptron, wynaleziony przez Franka Rosenblatta, prawdopodobnie położył podwaliny pod sztuczną inteligencję. Elektroniczny komputer analogowy był maszyną uczącą się, zaprojektowaną do przewidywania, czy obraz należy do jednej z dwóch kategorii. Ta rewolucyjna maszyna została wypełniona przewodami, które fizycznie łączyły ze sobą różne komponenty. Współczesne sztuczne sieci neuronowe stanowiące podstawę znanej sztucznej inteligencji, takie jak ChatGPT i DALL-E, to wersje oprogramowania Perceptronu, z wyjątkiem znacznie większej liczby warstw, węzłów i połączeń.

Podobnie jak we współczesnym uczeniu maszynowym, jeśli Perceptron zwróciłby błędną odpowiedź, zmieniłby swoje połączenia, aby móc lepiej przewidywać, co będzie dalej następnym razem. Znane nowoczesne systemy sztucznej inteligencji działają w podobny sposób. Korzystając z formatu opartego na przewidywaniach, duże modele językowe, czyli LLM, są w stanie generować imponujące, długie odpowiedzi tekstowe i kojarzyć obrazy z tekstem, tworząc nowe obrazy na podstawie podpowiedzi. Systemy te stają się coraz lepsze w miarę większej interakcji z użytkownikami.

Rozkwit i upadek AI

Mniej więcej dziesięć lat po odkryciu przez Rosenblatta Perceptronu Mark I eksperci tacy jak Marvin Minsky twierdzili, że od połowy do końca lat siedemdziesiątych na świecie „będzie istniała maszyna o ogólnej inteligencji przeciętnego człowieka”. Jednak pomimo pewnych sukcesów nigdzie nie udało się znaleźć ludzkiej inteligencji.

Szybko stało się jasne, że systemy sztucznej inteligencji nic nie wiedziały o swoim przedmiocie. Bez odpowiedniego wykształcenia i wiedzy kontekstowej prawie niemożliwe jest dokładne rozwiązanie niejasności występujących w języku potocznym – jest to zadanie, które ludzie wykonują bez wysiłku. Pierwsza „zima” sztucznej inteligencji, czyli okres rozczarowania, nastąpiła w 1974 r. w następstwie domniemanej awarii Perceptronu.

Jednak w 1980 r. sztuczna inteligencja powróciła do biznesu, a pierwszy oficjalny boom na sztuczną inteligencję był w pełnym rozkwicie. Pojawiły się nowe systemy eksperckie, sztuczna inteligencja zaprojektowana do rozwiązywania problemów w określonych obszarach wiedzy, które mogłyby identyfikować obiekty i diagnozować choroby na podstawie obserwowalnych danych. Istniały programy, które potrafiły wyciągać złożone wnioski z prostych historii, pierwszy samochód bez kierowcy był gotowy do wyruszenia w drogę, a dla publiczności na żywo grały roboty potrafiące czytać i odtwarzać muzykę.

Ale niedługo te same problemy ponownie stłumiły emocje. W 1987 r. nastąpił drugi zimowy hit AI. Systemy eksperckie zawodziły, ponieważ nie radziły sobie z nowymi informacjami.

Lata 90. zmieniły sposób, w jaki eksperci podchodzili do problemów związanych ze sztuczną inteligencją. Chociaż ostateczne odwilż drugiej zimy nie doprowadziło do oficjalnego boomu, sztuczna inteligencja przeszła istotne zmiany. Naukowcy zajęli się problemem zdobywania wiedzy za pomocą podejść do uczenia maszynowego opartych na danych, które zmieniły sposób zdobywania wiedzy przez sztuczną inteligencję.

Tym razem również nastąpił powrót do perceptronu w stylu sieci neuronowej, ale ta wersja była znacznie bardziej złożona, dynamiczna i, co najważniejsze, cyfrowa. Powrót do sieci neuronowej wraz z wynalezieniem przeglądarki internetowej i wzrostem mocy obliczeniowej ułatwił gromadzenie obrazów, wydobywanie danych i dystrybucję zbiorów danych do zadań uczenia maszynowego.

Znajome refreny

Przenieśmy się szybko do dnia dzisiejszego i zaufanie do postępu sztucznej inteligencji ponownie zaczęło odzwierciedlać obietnice złożone prawie 60 lat temu. Termin „sztuczna inteligencja ogólna” jest używany do opisania działań LLM, takich jak te obsługujące chatboty AI, takie jak ChatGPT. Sztuczna inteligencja ogólna (AGI) opisuje maszynę, która ma inteligencję równą ludzkiej, co oznacza, że maszyna byłaby samoświadoma, zdolna do rozwiązywania problemów, uczenia się, planowania przyszłości i ewentualnie świadoma.

Tak jak Rosenblatt uważał, że jego Perceptron stanowi podstawę świadomej maszyny przypominającej człowieka, tak samo myślą niektórzy współcześni teoretycy sztucznej inteligencji na temat współczesnych sztucznych sieci neuronowych. W 2023 roku Microsoft opublikował artykuł, w którym stwierdził, że „wydajność GPT-4 jest uderzająco bliska wydajności na poziomie ludzkim”.

Zanim jednak zaczniesz twierdzić, że LLM wykazują inteligencję na poziomie ludzkim, warto zastanowić się nad cykliczną naturą postępu AI. Wiele z tych samych problemów, które nawiedzały wcześniejsze wersje AI, występuje nadal. Różnica polega na tym, jak te problemy się manifestują.

Na przykład problem wiedzy występuje do dziś. ChatGPT nieustannie stara się reagować na idiomy, metafory, pytania retoryczne i sarkazm – unikalne formy języka, które wykraczają poza powiązania gramatyczne i zamiast tego wymagają wnioskowania o znaczeniu słów na podstawie kontekstu.

Sztuczne sieci neuronowe potrafią z imponującą dokładnością wybierać obiekty w złożonych scenach. Ale daj AI zdjęcie autobusu szkolnego leżącego na boku, a z całą pewnością powie, że to pług śnieżny w 97% przypadków.

Lekcje, których należy przestrzegać

W rzeczywistości okazuje się, że sztuczną inteligencję można dość łatwo oszukać w sposób, który ludzie natychmiast rozpoznają. Myślę, że warto to rozważyć poważnie, biorąc pod uwagę, jak sprawy potoczyły się w przeszłości.

Dzisiejsza sztuczna inteligencja wygląda zupełnie inaczej niż kiedyś, ale problemy z przeszłości pozostają. Jak to się mówi: historia może się nie powtarza, ale często się rymuje.

Danielle Williams jest stażystką podoktorską w dziedzinie filozofii nauki, sztuki i nauki na Washington University w St. Louis. Znajdź Danielle na X @okdaniellle

Wersja tego artykułu została pierwotnie opublikowana w Rozmowie i została opublikowana tutaj za zgodą. Każde ponowne opublikowanie powinno uwzględniać zarówno GLP, jak i oryginalny artykuł. Rozmowę można znaleźć na stronie X @RozmowaUS