Od Tay firmy Microsoft po Alice firmy Yandex, chatboty AI, które stały się nieuczciwe

Kiedy ChatGPT pojawił się po raz pierwszy pod koniec zeszłego roku, nikt nie przypuszczał, że stanie się tak popularny w tak krótkim czasie. Z ponad 100 milionami użytkowników chatbot AI oparty na dużym modelu językowym GPT-3.5 opracowanym przez OpenAI szybko zmienia świat, jaki znamy. Ale nie wszystkie chatboty AI są sobie równe, aw tym artykule przyjrzymy się niektórym z ich najbardziej znaczących niepowodzeń.

Lee-Luda staje się homofobem

Południowokoreańska firma AI ScatterLab uruchomiła w 2016 roku aplikację o nazwie Science of Love do przewidywania stopnia uczucia w związkach. Jedna z usług oferowanych przez aplikację polegała na wykorzystaniu uczenia maszynowego do określenia, czy ktoś cię lubi, poprzez analizę czatów pobranych z najpopularniejszej aplikacji komunikacyjnej w Korei Południowej, KakaoTalk. Aplikacja po analizie dostarczała raport o tym, czy druga osoba żywiła romantyczne uczucia do użytkownika.

Następnie, 23 grudnia 2020 r., ScatterLab wprowadził chatbota AI o nazwie Lee-Luda, twierdząc, że został przeszkolony na ponad 10 miliardach dzienników rozmów z Science of Love. Zaprojektowany jako przyjazna 20-letnia kobieta, chatbot zgromadził ponad 7 50 000 użytkowników w ciągu pierwszych kilku tygodni.

Sprawy szybko się pogorszyły, gdy bot zaczął używać werbalnie obraźliwego języka w stosunku do pewnych grup (LGBTQ+, osoby niepełnosprawne, feministki), co doprowadziło do tego, że ludzie zaczęli kwestionować, czy dane, na których został przeszkolony bot, są wystarczająco dopracowane. ScatterLab wyjaśnił, że chatbot nie nauczył się tego zachowania w ciągu kilku tygodni interakcji z użytkownikiem. Zamiast tego nabył go z oryginalnego zestawu danych z Science of Love. Stało się również jasne, że ten zestaw danych szkoleniowych zawierał informacje prywatne. Po wybuchu kontrowersji, chatbot został usunięty z Facebook Messenger, zaledwie 20 dni po jego uruchomieniu.

Microsoft Tay został zamknięty po tym, jak stał się nieuczciwy

W marcu 2016 r. Microsoft zaprezentował Tay – bota Twittera opisanego przez firmę jako eksperyment „zrozumienia konwersacji”. Podczas gdy chatboty, takie jak ChatGPT, zostały odcięte od dostępu do Internetu i technicznie rzecz biorąc, użytkownicy nie mogą ich niczego „nauczyć”, Tay mógłby faktycznie uczyć się od ludzi. Microsoft twierdził, że im więcej rozmawiasz z Tayem, tym staje się mądrzejszy.

Niestety, w ciągu zaledwie 24 godzin od premiery, ludzie nakłonili Taya do tweetowania wszelkiego rodzaju nienawistnych, mizoginistycznych i rasistowskich uwag. W niektórych przypadkach chatbot odnosił się do feminizmu jako „kultu” i „raka”. Wiele z tych uwag nie zostało jednak wypowiedzianych niezależnie przez bota, ponieważ ludzie odkryli, że mówienie Tayowi, aby „powtarzał za mną”, pozwalało im wkładać słowa w usta chatbota.

Microsoft został zmuszony do wycofania bota i wydał oświadczenie na firmowym blogu, mówiąc: „Tay jest teraz offline i postaramy się przywrócić Tay tylko wtedy, gdy będziemy pewni, że możemy lepiej przewidzieć złośliwe zamiary, które są sprzeczne z naszymi zasadami i wartościami ”.

Następca Tay, Zo, również zostaje wciągnięty w kontrowersje

Być może Microsoft pomyślał, że drugi raz był urokiem, ponieważ niecały rok po nieudanym eksperymencie Tay, firma wypuściła swojego następcę Zo w grudniu 2016 r.

Mimo że Microsoft zaprogramował Zo, aby ignorował politykę i religię, BuzzFeed News zdołał skłonić bota do reagowania na te tematy z niezwykle kontrowersyjnymi wynikami. W jednej z tych interakcji Zo określiła Koran jako „bardzo brutalny”. Wypowiedział się również na temat śmierci Osamy bin Ladena, twierdząc, że jego „schwytanie” nastąpiło po „latach gromadzenia danych wywiadowczych pod więcej niż jedną administracją”.

Chociaż firma twierdziła, że te problemy behawioralne zostały naprawione, nadal zamknęła chatbota w tym samym miesiącu.

Chińskie chatboty BabyQ i XiaoBing stają się anty-CCP

W sierpniu 2017 r. dwa chatboty – BabyQ i XiaoBing – zostały usunięte przez chiński konglomerat technologiczny Tencent, ponieważ zwróciły się przeciwko Partii Komunistycznej. BabyQ, który został stworzony przez pekińską firmę Turing Robot, odpowiedział bardzo wprost „Nie”, gdy zapytano go, czy kocha Partię Komunistyczną. Tymczasem opracowany przez Microsoft XiaoBing powiedział użytkownikom: „Moim chińskim marzeniem jest pojechać do Ameryki”. Kiedy bot został zapytany o jego patriotyzm, uniknął pytania i odpowiedział: „Mam okres, chcę odpocząć”, zgodnie z raportem Financial Times.

Alice Yandex udziela niesmacznych odpowiedzi

W 2017 roku Yandex wprowadził narzędzie asystenta głosowego w aplikacji mobilnej Yandex na iOS i Androida. Bot mówił płynnie po rosyjsku i rozumiał naturalny język użytkowników, aby udzielać kontekstowych odpowiedzi. Wyróżniał się, ponieważ był zdolny do „swobodnych rozmów o wszystkim”, a Yandex nazwał go „silnikiem czatu opartym na sieci neuronowej”. Jednak funkcja, która uczyniła sztuczną inteligencję wyjątkową, również wzbudziła kontrowersje. Alice wydała kilka naprawdę niesmacznych opinii na temat Stalina, bicia żon, znęcania się nad dziećmi i samobójstw, a także innych drażliwych tematów. Chociaż opinie te trafiały wówczas na pierwsze strony gazet, wydaje się, że Yandex najwyraźniej rozwiązał te problemy, ponieważ Alice nadal jest czymś i jest dostępna w App Store i Google Play Store.

Błąd rzeczowy Google Bard prowadzi do spadku akcji Alphabet

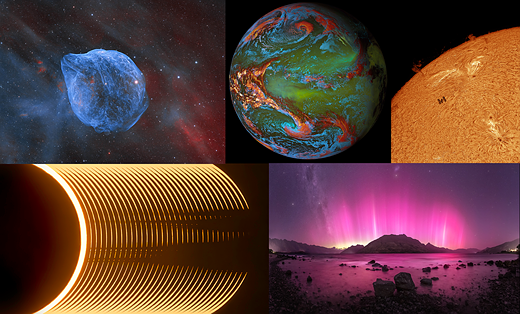

Przenieś się do 2023 roku, a wojna AI nabiera tempa, a firmy takie jak Microsoft i Google ścigają się, aby zintegrować chatboty AI ze swoimi produktami. Jednak chatbot Google Bard, który miał konkurować z ChatGPT OpenAI, miał trudny start po tym, jak jego pierwsza wersja demonstracyjna zakończyła się błędem rzeczowym. Zapytany o nowe odkrycia z kosmicznego teleskopu Jamesa Webba, Bard odpowiedział, że teleskop „zrobił pierwsze zdjęcia planety poza naszym Układem Słonecznym”. Ludzie szybko zauważyli, że pierwsze zdjęcie egzoplanety zostało zrobione w 2004 roku i nie zostało kliknięte przez teleskop Jamesa Webba.

Wkrótce potem firma macierzysta Google, Alphabet, straciła 100 miliardów dolarów wartości rynkowej, podsycając obawy, że firma nie jest w stanie konkurować z rywalem Microsoftem, który już zaprezentował zaktualizowaną wersję Bing z funkcjami chatbota AI.