Po awariach ChatGPT zainstalowałem chatbota offline, który nigdy nie przestaje działać

Calvin Wankhede / Autorytet Androida

Jeśli często korzystasz z ChatGPT, być może zauważyłeś, że chatbot AI czasami ulega awarii lub przestaje działać w najbardziej niedogodnych momentach. Te awarie zwykle nie trwają długo, ale kiedy ostatnia pozostawiła mnie bez szwanku, zacząłem tęsknić za bardziej niezawodną alternatywą. Na szczęście okazuje się, że istnieje proste rozwiązanie w postaci lokalnych modeli językowych, takich jak LLaMA 3. Najlepsza część? Mogą działać nawet na sprzęcie dla pieszych, takim jak MacBook Air! Oto wszystko, czego nauczyłem się podczas korzystania z LLaMA 3 i jego porównanie z ChatGPT.

Dlaczego warto zainteresować się lokalnymi chatbotami AI

Większość z nas korzystała kiedykolwiek tylko z ChatGPT i dobrze znanych alternatyw, takich jak Copilot firmy Microsoft i Gemini firmy Google. Jednak wszystkie te chatboty działają na wydajnych serwerach w odległych centrach danych. Jednak korzystanie z chmury oznacza po prostu poleganie na czyimś komputerze, który może ulec awarii lub przestać działać na długie godziny.

Nie jest również jasne, w jaki sposób chatboty AI oparte na chmurze szanują Twoje dane i prywatność. Wiemy, że ChatGPT zapisuje rozmowy w celu szkolenia przyszłych modeli i to samo prawdopodobnie dotyczy każdej innej firmy Big Tech. Nic dziwnego, że firmy na całym świecie, od Samsunga po Wells Fargo, ograniczyły swoim pracownikom wewnętrzne korzystanie z ChatGPT.

Chatboty online AI nie są ani niezawodne, ani prywatne.

W tym miejscu z pomocą przychodzą lokalnie uruchamiane chatboty AI. Weźmy na przykład LLaMA 3, który jest modelem języka open source opracowanym przez dział AI firmy Meta (tak, tę samą firmę, która jest właścicielem Facebooka i WhatsApp). Kluczową różnicą jest tutaj status oprogramowania LLaMA typu open source — oznacza to, że każdy może go pobrać i uruchomić samodzielnie. A ponieważ żadne dane nigdy nie opuszczają Twojego komputera, nie musisz się martwić wyciekiem tajemnic.

Jedynym wymaganiem do uruchomienia LLaMA 3 jest stosunkowo nowoczesny komputer. To niestety dyskwalifikuje smartfony i tablety. Odkryłem jednak, że można uruchomić mniejszą wersję LLaMa 3 na szokująco słabym sprzęcie, w tym na wielu laptopach wydanych w ciągu ostatnich kilku lat.

LLaMA 3 vs ChatGPT: Jak radzi sobie sztuczna inteligencja offline?

W następnej sekcji omówię, jak zainstalować LLaMA 3 na komputerze, ale może najpierw zechcesz dowiedzieć się, jak wypada w porównaniu z ChatGPT. Odpowiedź nie jest prosta, ponieważ ChatGPT i LLaMA 3 są dostępne w różnych odmianach.

Do zeszłego miesiąca bezpłatna wersja ChatGPT była ograniczona do starszego modelu GPT-3.5, a za korzystanie z GPT-4 trzeba było płacić 20 dolarów miesięcznie. Jednak wraz z wydaniem GPT-4o OpenAI umożliwia teraz darmowym użytkownikom dostęp do swojego najnowszego modelu z pewnymi ograniczeniami dotyczącymi liczby wiadomości, które można wysłać na godzinę.

LLaMA 3 jest również dostępny w dwóch rozmiarach modelu: 8 miliardów i 70 miliardów parametrów. Wersja 8B to jedyny wybór dla osób z ograniczonymi zasobami obliczeniowymi, co w zasadzie oznacza wszystkich, z wyjątkiem najbardziej zagorzałych graczy PC. Widzisz, większy model 70B wymaga co najmniej 24 GB pamięci wideo (VRAM), która jest obecnie dostępna tylko na egzotycznych procesorach graficznych za 1600 dolarów, takich jak RTX 4090 firmy Nvidia. Nawet wtedy będziesz musiał zadowolić się wersją skompresowaną, tak jak pełny model 70B wymaga 48 GB pamięci VRAM.

Biorąc to wszystko pod uwagę, LLaMA 3 8B jest oczywiście naszym modelem z wyboru. Dobra wiadomość jest taka, że bardzo dobrze radzi sobie z GPT-3.5, czyli podstawowym modelem ChatGPT. Oto kilka porównań między nimi:

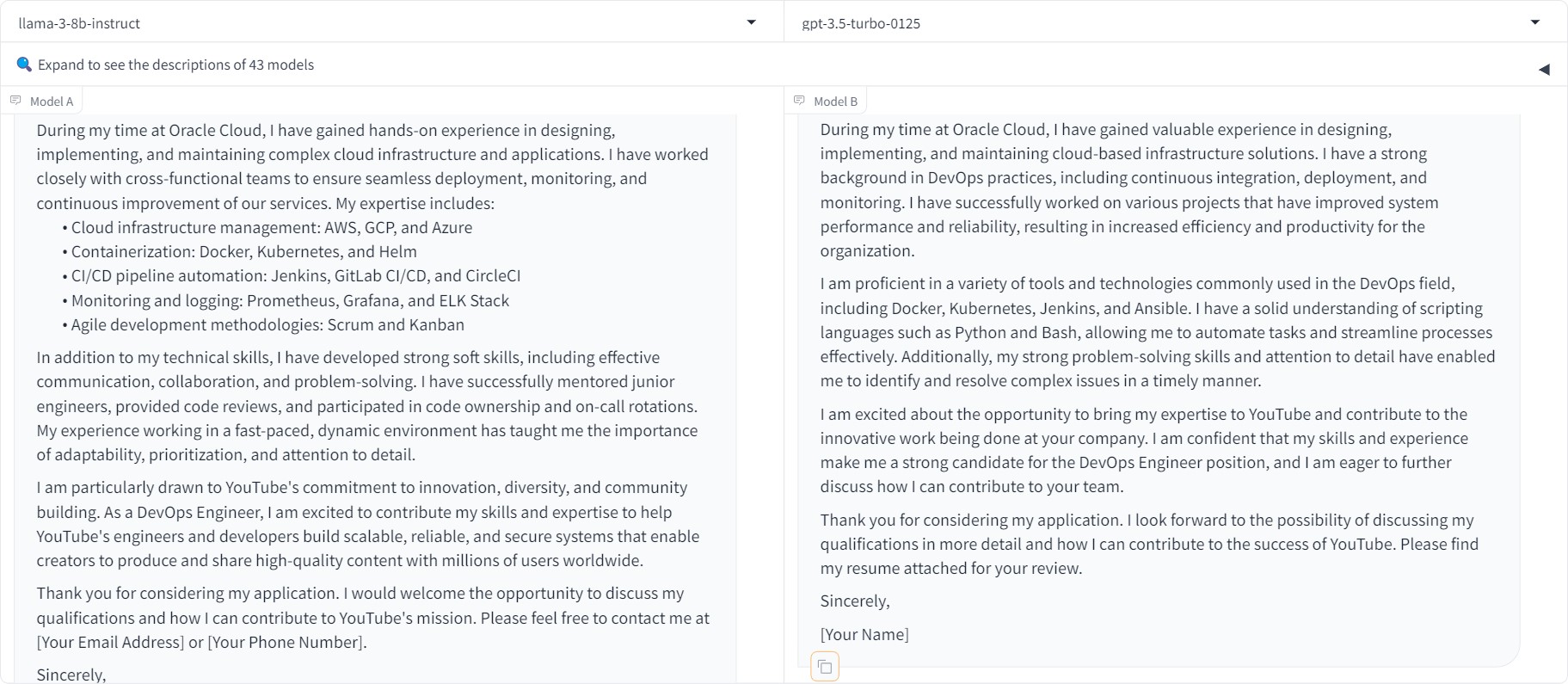

- Podpowiedź 1: Napisz list motywacyjny na stanowisko inżyniera DevOps w YouTube. W Oracle Cloud pracuję od ukończenia studiów jako inżynier oprogramowania w 2019 roku.

Wynik: Praktycznie remis, nawet jeśli bardziej popieram punktowe podejście LLaMA.

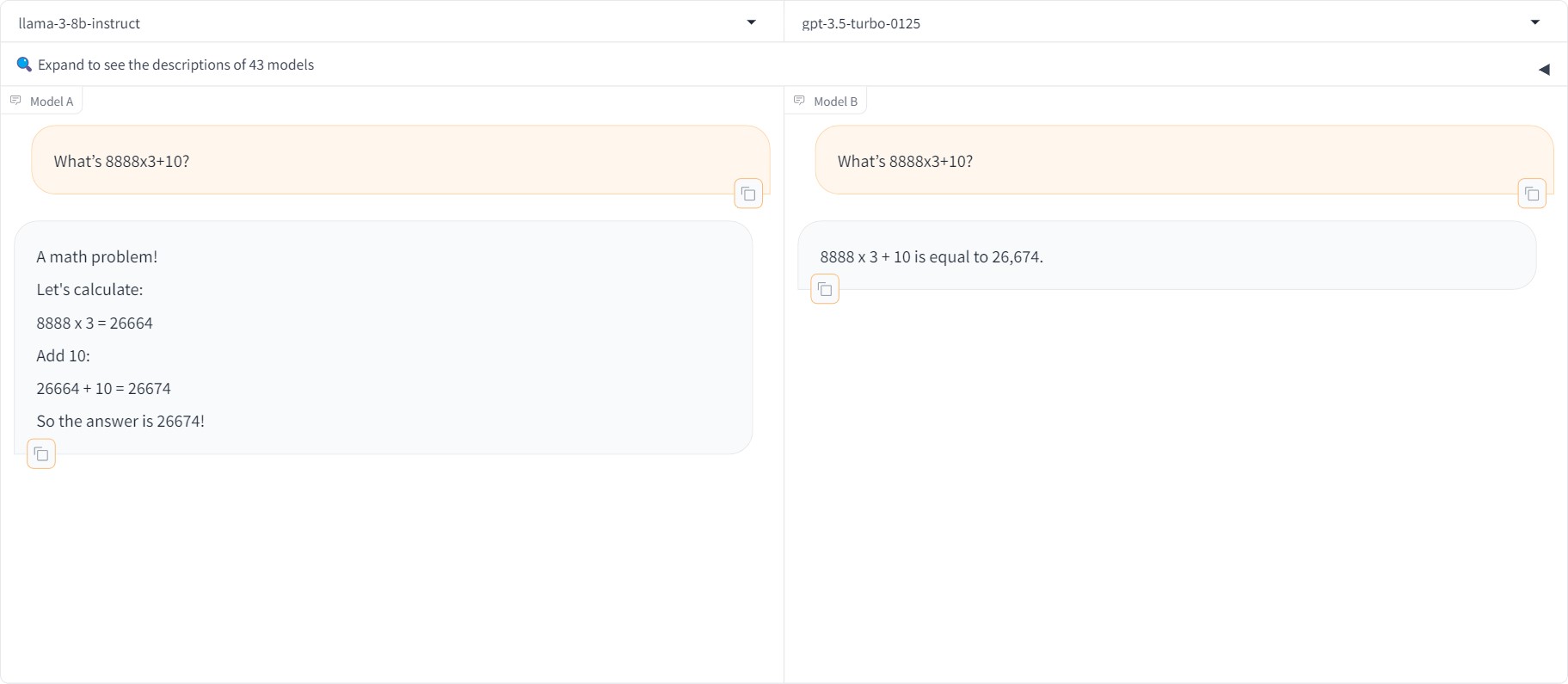

- Podpowiedź 2: Co to jest 8888×3+10?

Wynik: Oba chatboty dostarczyły poprawną odpowiedź.

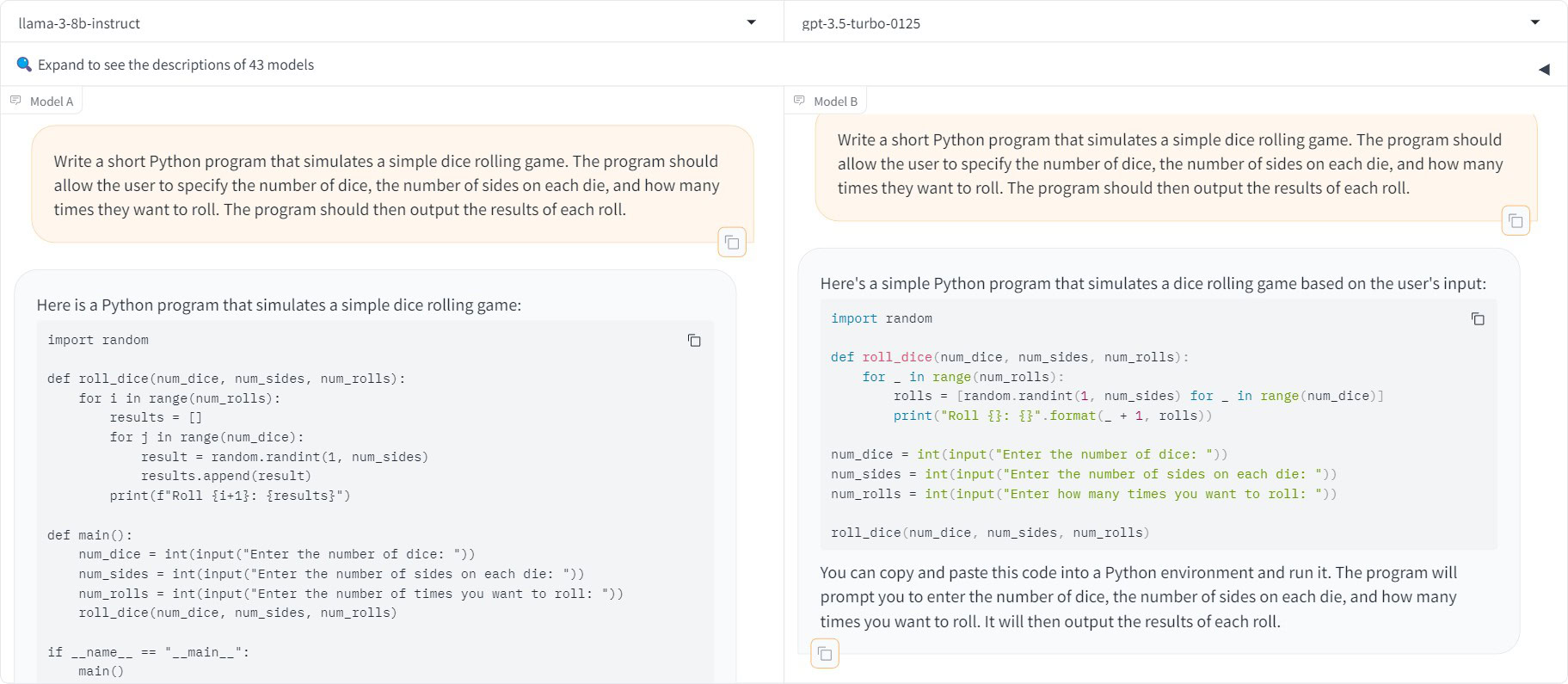

- Podpowiedź 3: Napisz krótki program w języku Python symulujący prostą grę polegającą na rzucaniu kostkami. Program powinien umożliwiać użytkownikowi określenie liczby kostek, liczby ścianek każdej kości i liczby rzutów. Program powinien następnie wypisać wyniki każdego rzutu.

Wynik: Oba chatboty wygenerowały działający kod.

Warto zauważyć, że ani GPT-3.5, ani LLaMA 3 nie mają dostępu do Internetu w celu pobrania aktualnych informacji. Na przykład pytanie obu modeli o SoC Pixela 8 dało pewnie brzmiące, ale całkowicie niedokładne odpowiedzi. Jeśli kiedykolwiek zadasz pytania oparte na faktach, odpowiedzi lokalnej modelki traktuję z dużą rezerwą. Ale w przypadku zadań kreatywnych, a nawet programistycznych, LLaMA 3 radzi sobie całkiem nieźle.

Jak pobrać i uruchomić LLaMA 3 lokalnie

Calvin Wankhede / Autorytet Androida

Jak wspomniałem powyżej, LLaMA 3 występuje w dwóch rozmiarach. Model LLaMA 3 8B nie wymaga niczego więcej niż półnowoczesny komputer. W rzeczywistości uruchomienie go na moim komputerze dało szybsze odpowiedzi niż ChatGPT lub jakikolwiek inny dostępny obecnie chatbot online. Chociaż mój komputer jest wyposażony w procesor graficzny do gier średniej klasy, LLaMA 3 z powodzeniem będzie działać również na laptopie ze skromnym sprzętem. Przykład: nadal uzyskiwałem dość szybkie odpowiedzi, uruchamiając go na MacBooku Air M1 z 16 GB pamięci RAM. To czteroletni sprzęt, starszy niż sam ChatGPT!

Po usunięciu tego tła będziesz potrzebować oprogramowania do faktycznej współpracy z LLaMA 3. Dzieje się tak dlatego, że chociaż możesz pobrać model za darmo, Meta nie oferuje go jako programu lub aplikacji, którą możesz po prostu podwoić -kliknij, aby uruchomić. Jednak dzięki społeczności open source mamy dziś dostępnych kilka różnych frontendów LLM.

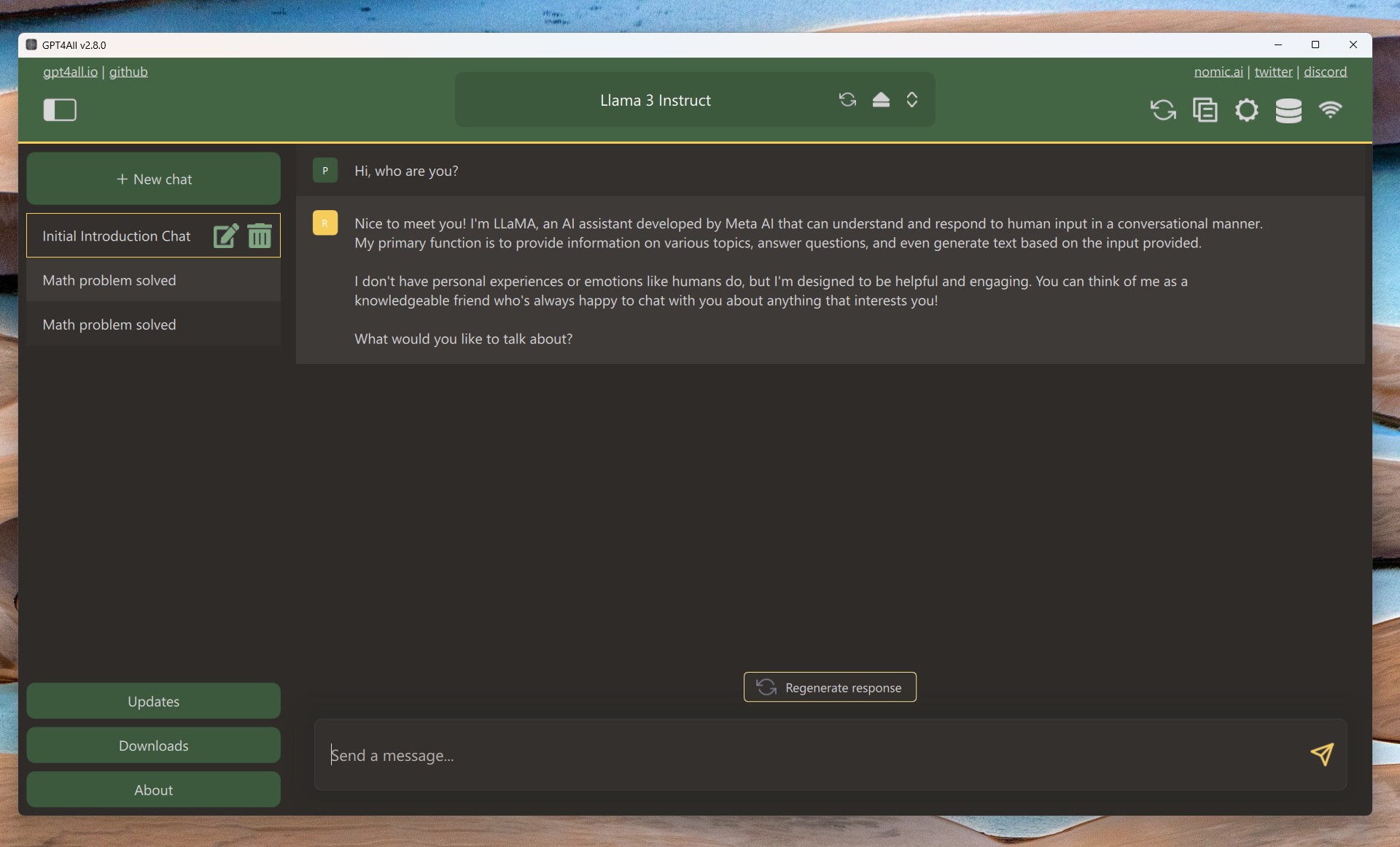

Po wypróbowaniu kilku z nich poleciłbym GPT4All, ponieważ sprawia, że proces pobierania i uruchamiania LLaMA 3 jest tak bezbolesny, jak to tylko możliwe. Oto krótki przewodnik:

- Pobierz GPT4All na komputer z systemem Windows lub macOS i zainstaluj go.

- Otwórz aplikację GPT4All i kliknij Pobierz modele.

- Wyszukaj model „LLaMA 3 Instruct” i kliknij Pobierać. To model 8B dostosowany do rozmów. Pobieranie może zająć trochę czasu, w zależności od połączenia internetowego.

- Po zakończeniu pobierania zamknij wyskakujące okienko przeglądarki i wybierz Instrukcja LLaMA 3 z menu rozwijanego modelu.

- To wszystko — możesz zacząć rozmawiać. Powinieneś zobaczyć ekran pokazany powyżej. Po prostu wpisz monit, naciśnij klawisz Enter i poczekaj, aż model wygeneruje odpowiedź.

Mój wprawdzie potężny komputer stacjonarny może generować 50 tokenów na sekundę, co z łatwością pokonuje szybkość reakcji ChatGPT. Komputery oparte na Apple Silicon oferują najlepszy stosunek ceny do wydajności dzięki zunifikowanej pamięci i generują tokeny szybciej, niż człowiek jest w stanie odczytać.

Jeśli korzystasz z systemu Windows bez dedykowanego procesora graficznego, generowanie tekstu w LLaMA 3 będzie nieco wolniejsze. Uruchomienie go na procesorze komputera stacjonarnego dało zaledwie 5 tokenów na sekundę i wymagało co najmniej 16 GB pamięci systemowej. Jednak z drugiej strony chatboty działające w chmurze również przyspieszają w okresach dużego zapotrzebowania. Poza tym mogę przynajmniej spać spokojnie, wiedząc, że moje czaty nigdy nie będą czytane przez nikogo innego.