Robotnicy mechaniczni Turków używają sztucznej inteligencji do automatyzacji bycia człowiekiem

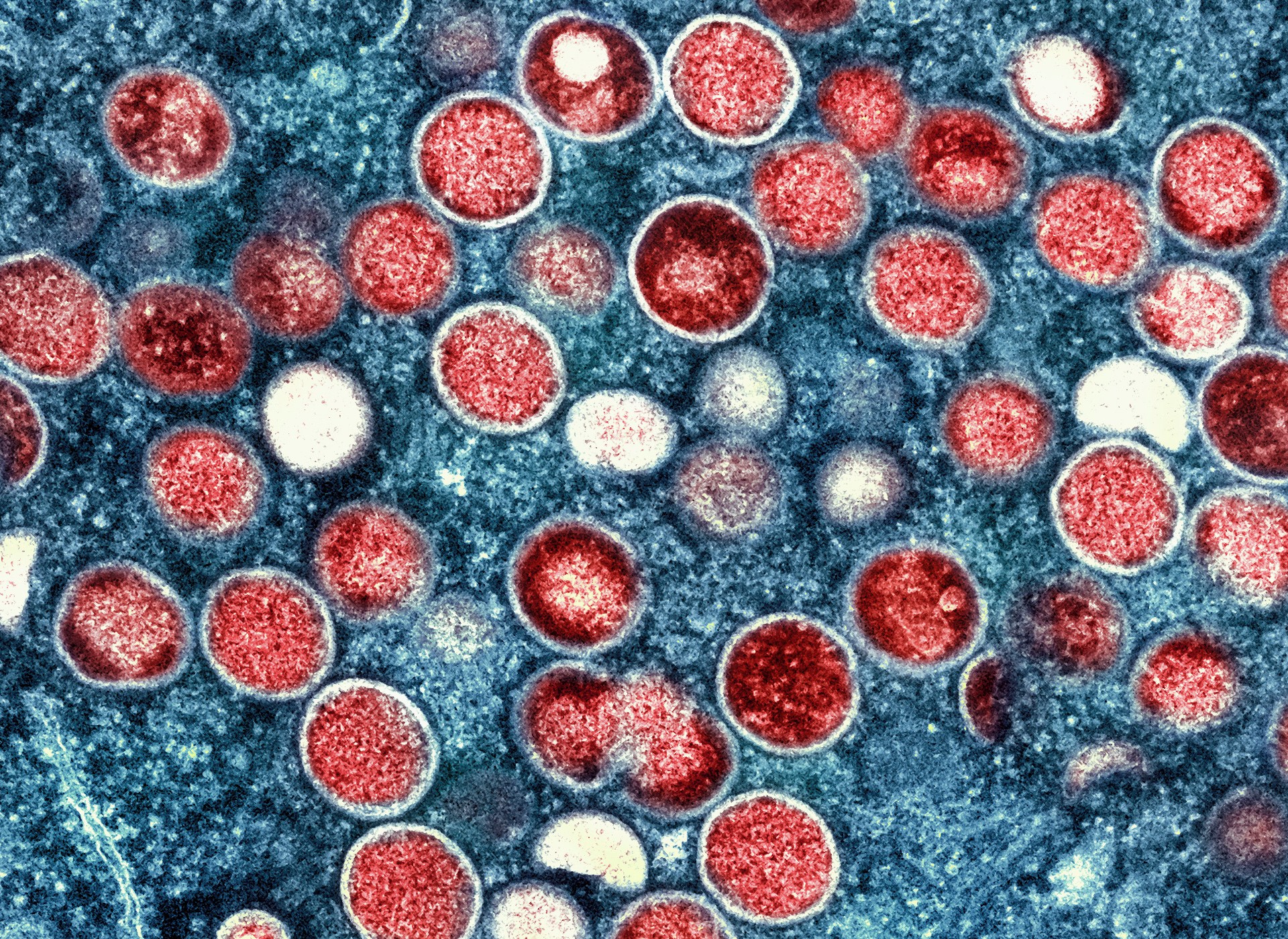

Kredyty obrazkowe: API/Gamma-Raphio/Getty/Getty Images

Złóż ten pod nieuniknionym, ale przezabawnym. Mechanical Turk to usługa, która od samego początku zdawała się zapraszać shenaniganów i rzeczywiście badacze pokazują, że prawie połowa jej „turkerów” wydaje się wykorzystywać sztuczną inteligencję do wykonywania zadań, które były specjalnie przeznaczone do wykonania przez ludzi, ponieważ sztuczna inteligencja nie mogła. Zamknęliśmy pętlę w tej sprawie; świetna robota wszystkim!

Amazon Mechanical Turk pozwala użytkownikom dzielić proste zadania na dowolną liczbę małych podzadań, których wykonanie zajmuje tylko kilka sekund i które płacą grosze – ale oddani pracownicy fragmentaryczni wykonaliby tysiące, a tym samym uzyskaliby skromne, ale solidne wynagrodzenie. Była to, jak pamiętnie ujął to Jeff Bezos, „sztuczna sztuczna inteligencja”.

Były to zazwyczaj zadania trudne do zautomatyzowania — takie jak CAPTCHA lub określenie nastroju zdania lub proste „narysowanie koła wokół kota na tym obrazku”, które ludzie mogli wykonać szybko i niezawodnie. Był swobodnie używany przez osoby oznaczające stosunkowo złożone dane i badaczy dążących do uzyskania ludzkich ocen lub decyzji na dużą skalę.

Został nazwany na cześć słynnego „automatu” do gry w szachy, który faktycznie wykorzystywał człowieka ukrywającego się w swojej bazie do wykonywania swoich partii – Poe napisał świetne współczesne zdjęcie tego. Czasami automatyzacja jest trudna lub niemożliwa, ale w takich przypadkach można zrobić z ludzkości coś w rodzaju maszyny. Trzeba na to uważać, ale przez lata sprawdziło się.

Ale badanie przeprowadzone przez naukowców z EPFL w Szwajcarii pokazuje, że pracownicy Mechanical Turk automatyzują swoją pracę za pomocą dużych modeli językowych, takich jak ChatGPT: wąż gryzący własny ogon lub być może całkowicie połykający.

Pytanie pojawiło się, gdy rozważali skorzystanie z usługi takiej jak MTurk jako „człowieka w pętli” w celu poprawy lub sprawdzenia faktów odpowiedzi LLM, które są zasadniczo niewiarygodne:

Kuszące jest poleganie na crowdsourcingu w celu walidacji wyników LLM lub tworzenia danych o ludzkim złotym standardzie do porównania. Ale co, jeśli sami pracownicy społecznościowi korzystają z LLM, np. w celu zwiększenia swojej produktywności, a tym samym swoich dochodów, na platformach crowdsourcingowych?

Aby uzyskać ogólne pojęcie o problemie, przydzielili Turkom zadanie „abstrakcyjnego podsumowania”. Na podstawie różnych analiz opisanych w artykule (nadal nieopublikowanym ani recenzowanym) „szacują, że 33–46% pracowników społecznościowych korzystało z LLM podczas wykonywania zadania”.

Dla niektórych nie będzie to zaskoczeniem. Pewien poziom automatyzacji prawdopodobnie istniał w Turku od momentu powstania platformy. Szybkość i niezawodność są motywowane, a gdybyś mógł napisać skrypt, który obsługiwałby określone żądania z 90% dokładnością, mógłbyś zarobić sporo pieniędzy. Przy tak niewielkim nadzorze procesów poszczególnych współpracowników było nieuniknione, że niektóre z tych zadań nie będą faktycznie wykonywane przez ludzi, jak reklamowano. Uczciwość nigdy nie była mocną stroną Amazona, więc nie było sensu na nich polegać.

Ale zobaczenie tego w ten sposób i zadanie, które do niedawna wydawało się, że może wykonać tylko człowiek – odpowiednio podsumować streszczenie artykułu – kwestionuje nie tylko wartość Mechanical Turk, ale ujawnia inny front w nadchodzącym kryzysie „ Szkolenie AI na danych generowanych przez AI” w kolejnym trudnym położeniu w stylu Ouroboros.

Badacze (Veniamin Veselovsky, Manoel Horta Ribeiro i Robert West) ostrzegają, że zadanie to, od czasu pojawienia się nowoczesnych LLM, jest szczególnie odpowiednie dla ukrytej automatyzacji, a zatem szczególnie prawdopodobne, że padnie ofiarą tych metod. Ale stan techniki stale się rozwija:

LLM stają się z dnia na dzień coraz bardziej popularne, a modele multimodalne, obsługujące nie tylko tekst, ale także wprowadzanie i wyprowadzanie obrazów i wideo, stają się coraz popularniejsze. W związku z tym nasze wyniki należy uznać za „kanarka w kopalni węgla”, który powinien przypominać platformom, badaczom i pracownikom społecznościowym o znalezieniu nowych sposobów zapewnienia, że dane ludzkie pozostaną ludzkie.

Zagrożenie związane z jedzeniem przez sztuczną inteligencję było teoretyzowane od wielu lat i stało się rzeczywistością niemal natychmiast po powszechnym wdrożeniu LLM: zwierzak Binga, ChatGPT, zacytował własne dezinformacje jako wsparcie dla nowych dezinformacji na temat spisku COVID.

Jeśli nie możesz być w 100% pewien, że coś zostało zrobione przez człowieka, prawdopodobnie lepiej będzie założyć, że tak nie było. To przygnębiająca zasada, której trzeba przestrzegać, ale oto jesteśmy.