Niebezpieczeństwa związane z poleganiem na chatbotach AI zajmujących się zdrowiem psychicznym

Przy obecnych barierach fizycznych i finansowych w dostępie do opieki osoby cierpiące na choroby psychiczne mogą zwrócić się do chatbotów opartych na sztucznej inteligencji (AI), aby uzyskać ulgę lub pomoc w zakresie zdrowia psychicznego. Chociaż nie zostały one zatwierdzone jako wyroby medyczne przez amerykańską Agencję ds. Żywności i Leków ani przez Health Canada, atrakcyjność takich chatbotów może wynikać z ich całodobowej dostępności, spersonalizowanego wsparcia i marketingu terapii poznawczo-behawioralnej.

Użytkownicy mogą jednak przeceniać korzyści terapeutyczne i nie doceniać ograniczeń stosowania takich technologii, co dodatkowo pogarsza ich zdrowie psychiczne. Takie zjawisko można zakwalifikować jako błędne przekonanie terapeutyczne, z którego użytkownicy mogą wywnioskować, że celem chatbota jest zapewnienie im prawdziwej opieki terapeutycznej.

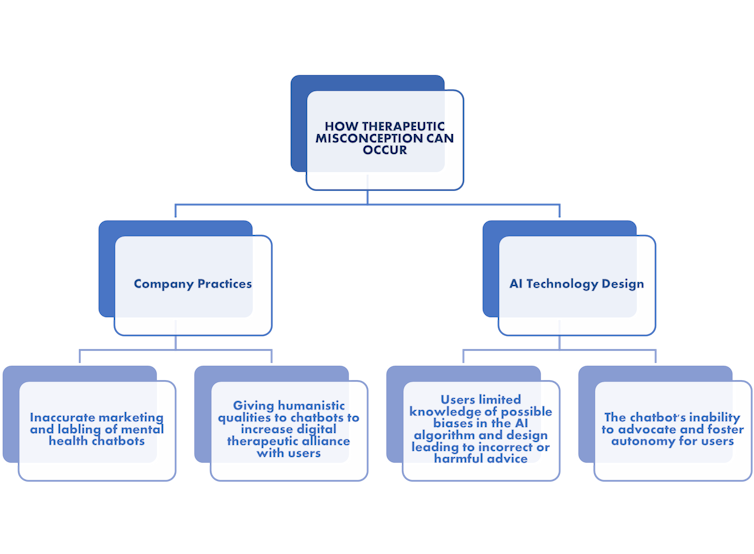

W przypadku chatbotów AI błędne przekonania terapeutyczne mogą pojawiać się na cztery sposoby, w dwóch głównych nurtach: praktyki firmy i projekt samej technologii AI.

(Zoha Khawaja)

Praktyki firmy: Poznaj swojego eksperta w zakresie samopomocy AI

Po pierwsze, nieprawidłowy marketing chatbotów zajmujących się zdrowiem psychicznym prowadzony przez firmy, które oznaczają je jako narzędzia „wsparcia zdrowia psychicznego” zawierające „terapię poznawczo-behawioralną”, może być bardzo mylący, ponieważ sugeruje, że takie chatboty mogą przeprowadzać psychoterapię.

Takim chatbotom nie tylko brakuje umiejętności, przeszkolenia i doświadczenia ludzkich terapeutów, ale etykietowanie ich jako zdolnych zapewnić „inny sposób leczenia” chorób psychicznych sugeruje, że takie chatboty mogą być wykorzystywane jako alternatywne sposoby szukania terapii.

Tego rodzaju taktyka marketingowa może w dużym stopniu wykorzystywać zaufanie użytkowników do systemu opieki zdrowotnej, zwłaszcza gdy są reklamowani jako osoby pozostające w „ścisłej współpracy z terapeutami”. Taka taktyka marketingowa może prowadzić użytkowników do ujawniania bardzo osobistych i prywatnych informacji zdrowotnych bez pełnego zrozumienia, kto jest właścicielem ich danych i ma do nich dostęp.

Drugi rodzaj błędnego przekonania terapeutycznego ma miejsce wtedy, gdy użytkownik tworzy cyfrowy sojusz terapeutyczny z chatbotem. W przypadku ludzkiego terapeuty korzystne jest utworzenie silnego sojuszu terapeutycznego, w którym zarówno pacjent, jak i terapeuta współpracują i uzgadniają pożądane cele, które można osiągnąć poprzez zadania, a także tworzą więź zbudowaną na zaufaniu i empatii.

Ponieważ chatbot nie może nawiązać takiej samej relacji terapeutycznej, jak użytkownicy mogą z ludzkim terapeutą, może powstać cyfrowy sojusz terapeutyczny, w którym użytkownik postrzega sojusz z chatbotem, mimo że chatbot w rzeczywistości nie może go utworzyć.

(Zoha Khawaja)

Włożono wiele wysiłku w zdobycie zaufania użytkowników i wzmocnienie cyfrowego sojuszu terapeutycznego za pomocą chatbotów, w tym nadanie chatbotom humanistycznych cech przypominających i naśladujących rozmowy z rzeczywistymi terapeutami oraz reklamowanie ich jako „anonimowych” towarzyszy całodobowych, 7 dni w tygodniu, którzy mogą naśladować aspekty terapii .

Taki sojusz może sprawić, że użytkownicy nieumyślnie będą oczekiwać takiej samej poufności i ochrony prywatności od pacjenta do świadczeniodawcy, jaką oczekiwaliby od swoich dostawców usług opieki zdrowotnej. Niestety, im bardziej zwodniczy jest chatbot, tym skuteczniejszy będzie cyfrowy sojusz terapeutyczny.

Projekt technologiczny: Czy Twój chatbot jest przeszkolony, aby Ci pomóc?

Trzecie błędne przekonanie terapeutyczne ma miejsce, gdy użytkownicy mają ograniczoną wiedzę na temat możliwych błędów w algorytmie sztucznej inteligencji. Często osoby marginalizowane są pomijane na etapach projektowania i rozwoju takich technologii, co może prowadzić do otrzymania stronniczych i niewłaściwych odpowiedzi.

Przeczytaj więcej: Sztuczna inteligencja może dyskryminować ze względu na rasę i płeć, a także wiek

Gdy takie chatboty nie są w stanie rozpoznać ryzykownych zachowań lub zapewnić odpowiednich kulturowo i językowo zasobów w zakresie zdrowia psychicznego, może to pogorszyć stan zdrowia psychicznego bezbronnych grup społecznych, które nie tylko spotykają się z napiętnowaniem i dyskryminacją, ale także nie mają dostępu do opieki. Błędne przekonanie terapeutyczne ma miejsce, gdy użytkownicy mogą oczekiwać, że chatbot przyniesie im korzyści terapeutyczne, ale otrzymają szkodliwe porady.

Wreszcie, błędne przekonanie terapeutyczne może wystąpić, gdy chatboty zajmujące się zdrowiem psychicznym nie są w stanie opowiadać się za autonomią relacyjną i ją wspierać – jest to koncepcja, która podkreśla, że autonomia jednostki jest kształtowana przez jej relacje i kontekst społeczny. Obowiązkiem terapeuty jest wówczas pomoc w odzyskaniu autonomii pacjenta poprzez wspieranie go i motywowanie do aktywnego zaangażowania w terapię.

Chatboty AI stanowią paradoks, w którym są dostępne 24 godziny na dobę, 7 dni w tygodniu i obiecują poprawę samowystarczalności w zarządzaniu swoim zdrowiem psychicznym. Może to nie tylko sprawić, że zachowania związane z poszukiwaniem pomocy będą wyjątkowo izolujące i zindywidualizowane, ale także stworzy błędne przekonanie terapeutyczne, w którym jednostki będą wierzyć, że samodzielnie podejmują pozytywny krok w kierunku poprawy swojego zdrowia psychicznego.

Fałszywe poczucie dobrostanu powstaje, gdy kontekst społeczny i kulturowy danej osoby oraz niedostępność opieki nie są uważane za czynniki przyczyniające się do jej zdrowia psychicznego. To fałszywe oczekiwanie jest jeszcze bardziej uwydatnione, gdy chatboty są błędnie reklamowane jako „agenci relacyjni”, którzy mogą „tworzyć więź z ludźmi… porównywalną do tej, jaką osiągają terapeuci za pomocą ludzi”.

Środki mające na celu uniknięcie ryzyka błędnego przekonania terapeutycznego

Nie cała nadzieja stracona w przypadku takich chatbotów, ponieważ można podjąć pewne proaktywne kroki, aby zmniejszyć prawdopodobieństwo błędnych przekonań terapeutycznych.

Dzięki uczciwemu marketingowi i regularnym przypomnieniom użytkownicy mogą być świadomi ograniczonych możliwości terapeutycznych chatbota i zachęcani do poszukiwania bardziej tradycyjnych form terapii. Tak naprawdę należałoby udostępnić terapeutę osobom, które chciałyby zrezygnować z korzystania z takich chatbotów. Użytkownicy odnieśliby również korzyść z przejrzystości w zakresie gromadzenia, przechowywania i wykorzystywania ich informacji.

Należy również rozważyć aktywne zaangażowanie pacjentów na etapach projektowania i opracowywania takich chatbotów, a także współpracę z wieloma ekspertami w zakresie wytycznych etycznych, które mogą regulować i regulować takie technologie, aby zapewnić użytkownikom lepszą ochronę.